蚂蚁技巧研究院宣布推出 LLaDA2.0 系列离散扩散大年夜说话模型(dLLM),并同步公开了背后的技巧申报,传播鼓吹是“业内首个 100B 扩散说话模型”。

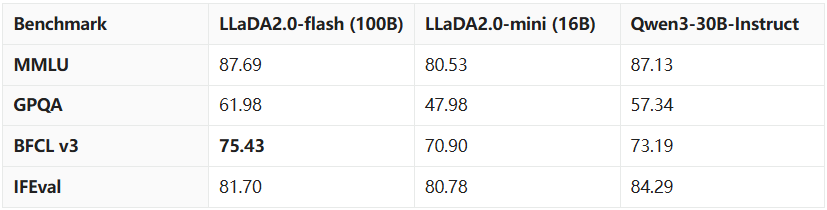

LLaDA2.0 包含 MoE 架构的 16B (mini) 和 100B (flash) 两个版本,将 Diffusion 模型的参数范围初次扩大到了 100B 量级。据介绍,此次宣布的模型不仅打破了扩散模型难以扩大的固有印象,更在代码、数学和智能体义务上展示出了超出同级自回归(AR)模型的机能。

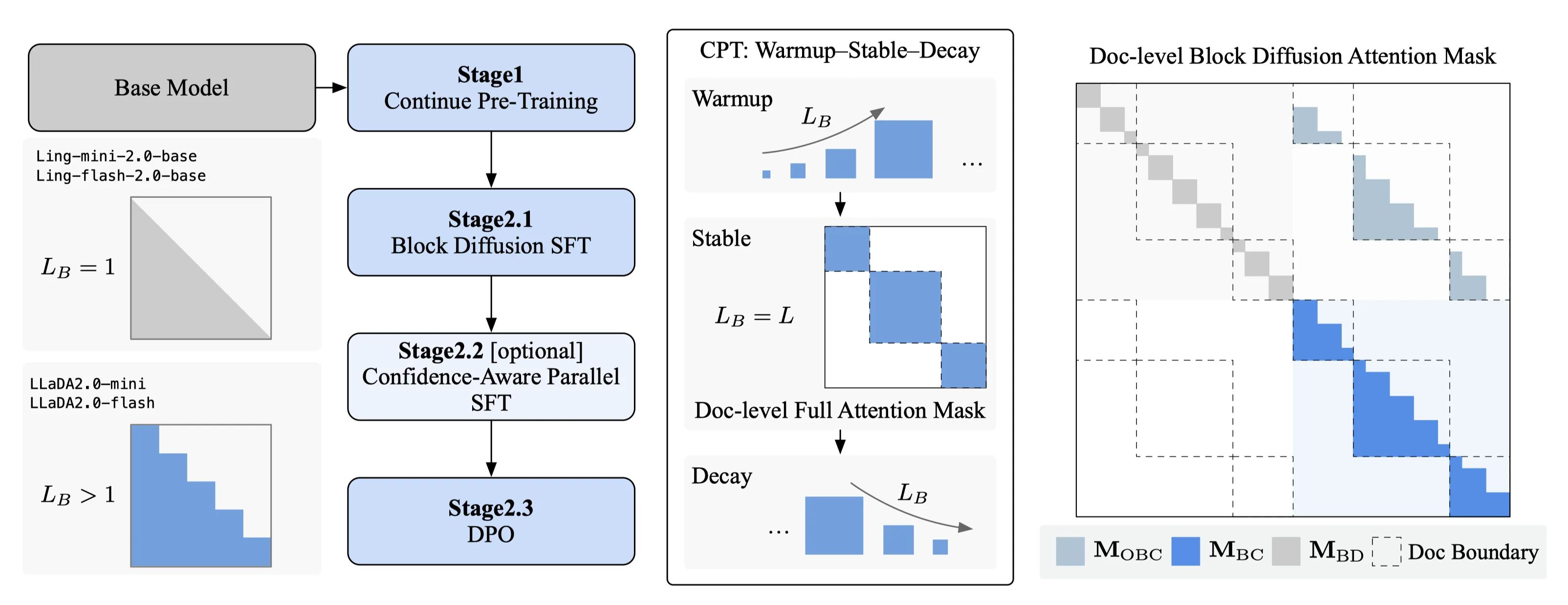

经由过程立异的 Warmup-Stable-Decay(WSD)持续预练习策略,LLaDA2.0 可以或许无缝持续现有 AR 模型的常识,避免了从头练习的昂扬成本。结合不仅限于惯例 SFT 的 置信度感知并行练习(CAP)和 扩散模型版 DPO,LLaDA2.0 在包管生成质量的同时,应用扩散模型的并行解码优势,实现了比拟 AR 模型 2.1 倍的推理加快,证清楚明了在超大年夜范围参数下,扩散模型不仅可行,并且更强、更快。

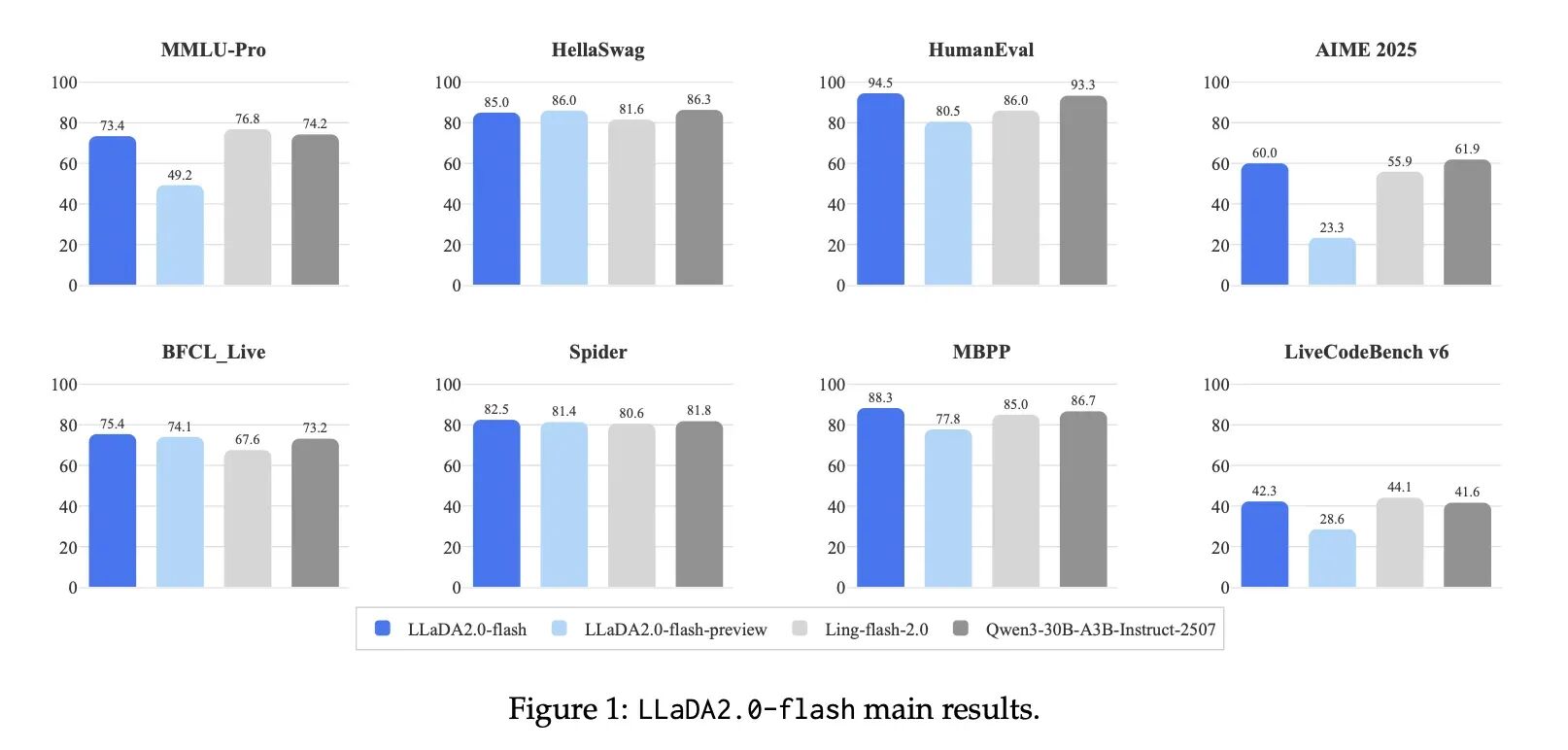

蚂蚁技巧研究院在常识懂得、数学、代码、推理 & 智能体等多个维度对模型进行了评估。成果显示,LLaDA2.0 在构造化生成义务(如代码)上具有明显优势,并在其他范畴与开源 AR 模型持平。

https://huggingface.co/collections/inclusionAI/llada-20

LLaDA2.0 的模型权重(16B/100B)及相干练习代码均已开源:

https://github.com/inclusionAI/LLaDA2.0

发表评论 取消回复