苹果宣布了名为 SHARP(Sharp Monocular View Synthesis)的研究成果和模型,可以在不到一秒钟内从一张通俗的二维照片生成一个具有逼真后果的三维场景视图。

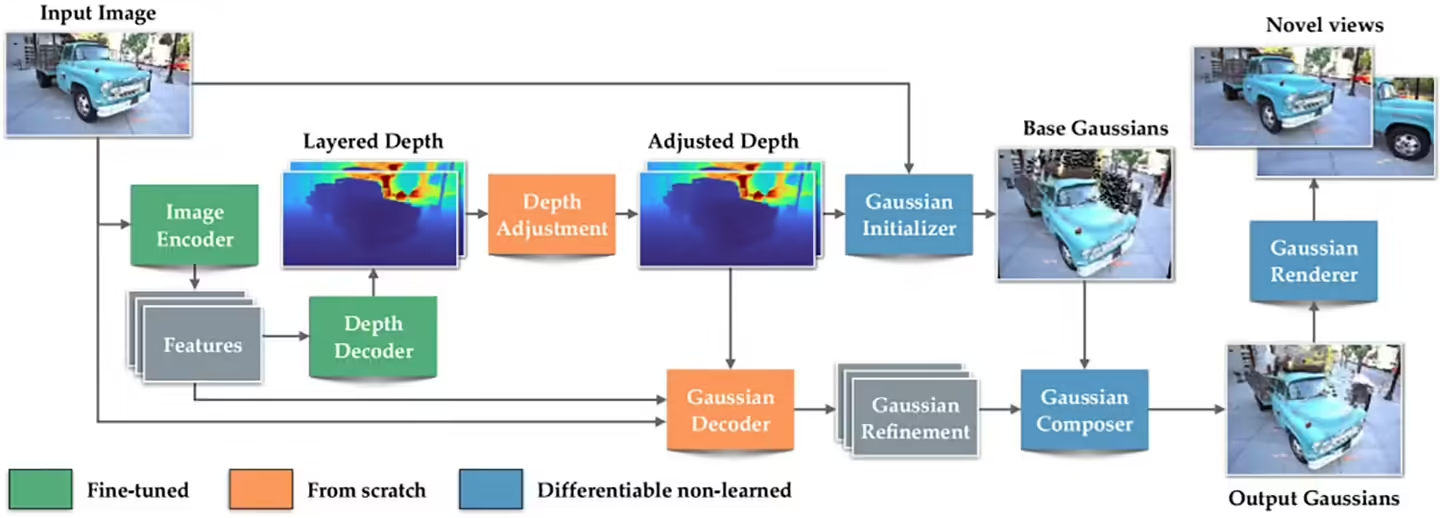

据介绍,SHARP 应用先辈的 3D 高斯泼溅(3D Gaussian Splatting) 技巧,将场景表示为大年夜量带有色彩和光照信息的 3D 高斯球体。模型经由过程单次神经收集前向推理(feedforward),猜测出数百万个这些高斯球的地位和外不雅,从而重建出三维后果。

与传统办法须要多角度图像或长时光优化不合,SHARP 能做到单图输入 + 快速输出,其输出的 3D 表示保持真实比例与深度,支撑真实标准的相机视角移动。在多个标准数据集上,它在图像质量指标(如 LPIPS、DISTS)上优于现有办法,同时速度晋升约 1000 倍。

苹果已将 SHARP 的代码和模型权重宣布到 GitHub:https://github.com/apple/ml-sharp

发表评论 取消回复