AReaL 是一个面向算法设计,以开辟效力和灵活性为核心的强化进修框架,由蚂蚁百灵大年夜模型团队开源。它经由过程极简的 API 和可扩大的插件机制降低用户的进修曲线和运居心智包袱,闪开辟者聚焦于算法本身而非体系细节,具备大年夜范围扩大、无侵入 Agentic RL、故障感知与自恢复等才能。

该项目近日宣布新版本 v0.5.0,带来懂得耦式 Agentic RL,以及 Single Controller 架构两个核心特点。

- 解耦式 Agentic RL

AReaL 经由过程 OpenAI API 代理,供给了一套解耦化的智能体练习办事解决筹划,便于情况供给者、算法开辟者和体系开辟者形成复杂工程中的零障碍流水线,极大年夜晋升了开辟效力与体系可保护性。

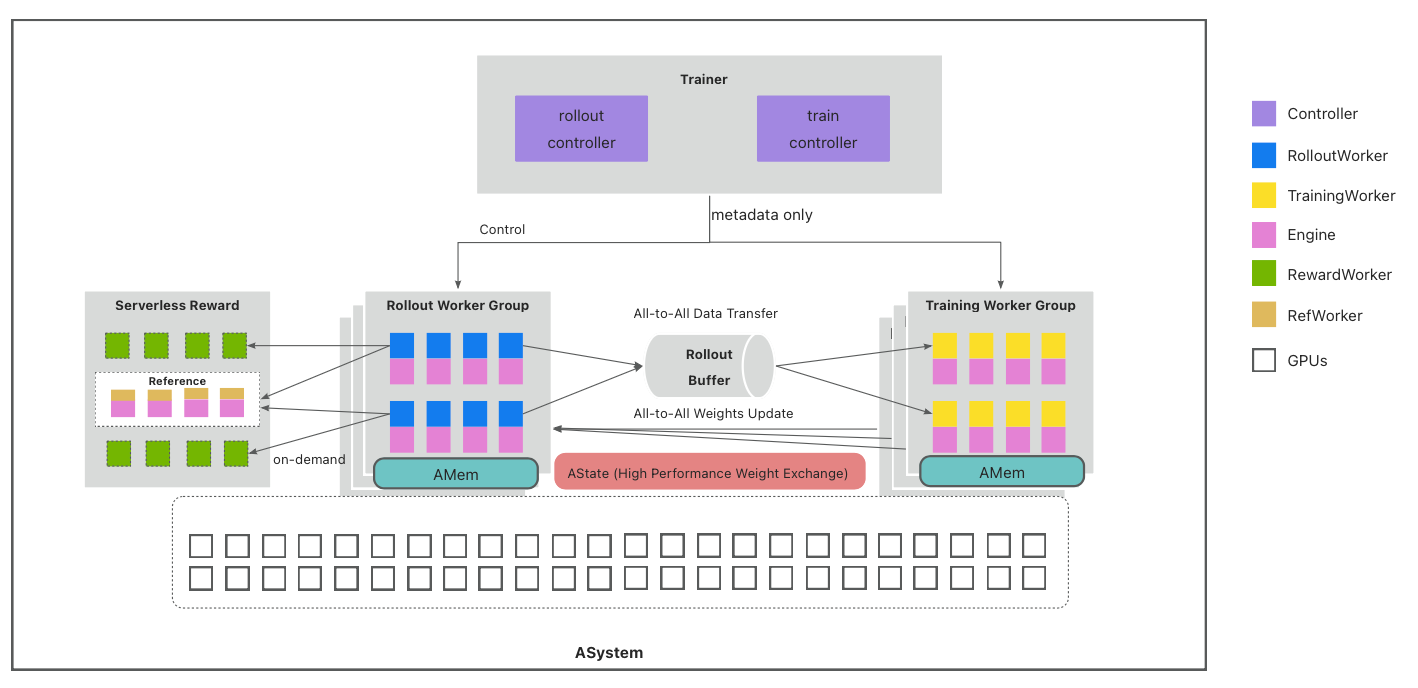

- Single Controller 架构

1. Agent 完全自力运行(Agent Autonomy)

在 AReaL 框架中,Agent 本身不依附任何 RL 框架的组件,也不感知自身正在被用于练习。它只是一个标准的、基于大年夜说话模型(LLM)的决定计划体系,按照既定的编排逻辑接收输入、调用对象、生成动作并输出成果。这种设计确保了 Agent 的纯净性与可移植性——同一个 Agent 实现既可以用于在线推理,也可以无缝接入离线练习,真正做到"一套代码,两处复用"。

AReaL Agentic RL 的架构设计建立在两个核心原则之上:

2. RL 练习作为外部不雅察者(RL as Observer)

AReaL 不主动干涉 Agent 的履行流程,而是经由过程"代理请求"的方法,监听并记录 Agent 与情况交互的完全轨迹(Trajectory)。这些轨迹包含:用户输入、Agent 的思维链(Thought)、调用的动作(Action)、情况反馈(Observation)以及最终的嘉奖旌旗灯号(Reward)。经由过程这种方法,AReaL 将复杂的 Agent 履行过程转化为标准的 RL 练习数据,从而可以应用随便率性成熟的 RL 算法进行策略优化。

清除了 SPMD (Single Program, Multiple Data) 模式的长尾和数据不平均问题,这种分层设计既能晋升推理扩大性、加强体系层面精细化控制,又能保存算法编排的灵活易用性,降低算法开辟者代码迁徙的成本。

Single Controller 架构如下:

下载地址:https://github.com/inclusionAI/AReaL/releases/tag/v0.5.0

发表评论 取消回复